Google のセキュア AI フレームワーク

(SAIF)

AI、特に生成 AI がもたらす可能性は無限大です。イノベーションが進むにつれて、業界では責任を持って AI を開発し導入するためのセキュリティ基準が求められています。そのため Google は、AI システムを安全に保護するための概念的なフレームワークであるセキュア AI フレームワーク(SAIF)を導入しました。

SAIF の 6 つの基本要素

-

強固なセキュリティ基盤を AI エコシステムまで拡大する

-

検出機能と対応機能を拡張し、組織の脅威対策に AI を取り込む

-

防御を自動化し、既存および新規の脅威に対応する

-

プラットフォーム レベルの管理を調整し、組織全体で一貫したセキュリティを確保する

-

管理を適応させて緩和策を調整し、AI デプロイ用に高速なフィードバック ループを作成する

-

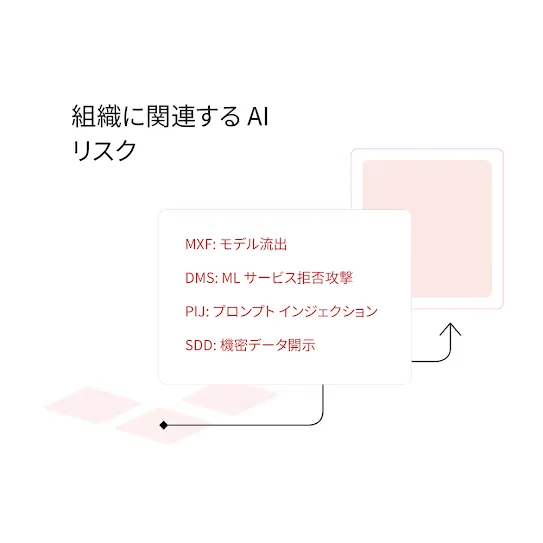

周囲のビジネス プロセスにおける AI システムのリスクをコンテキスト化する

より安全なエコシステムの実現

その他のリソース

SAIF に関する

よくある質問

Google には、責任ある AI とサイバーセキュリティの開発を推進してきた長い歴史があり、長年にわたり、セキュリティのベスト プラクティスを AI イノベーションに適用してきました。セキュア AI フレームワークは、Google が開発し実装してきたこれまでの経験とベスト プラクティスから生まれたものです。ML や生成 AI を活用したアプリケーションの開発において、レスポンシブ、サステナブル、スケーラブルを実現するセキュリティ保護およびプライバシー保護を重視するという Google の取り組みを反映しています。Google は、新たなリスク、状況の変化、AI の進歩に対応するため、SAIF の改良と構築を続けていきます。

SAIF のフレームワークを導入するための クイックガイド をご覧ください。

- ステップ 1 - 用途を理解する

- AI で解決できる具体的なビジネス上の問題と、モデルのトレーニングに必要なデータを理解しましょう。SAIF の一部として導入が必要なポリシー、プロトコル、コントロールを設定する際の指針となります。

- ステップ 2 - チームを編成する

- AI システムの開発とデプロイは、従来のシステムと同様に、多分野にまたがる取り組みです。

- AI システムは多くの場合、複雑で不明瞭であり、不確定要素が多く大量のデータに依存し、多くのリソースを必要とします。また、AI システムは評価に基づく決定を下すために使用される場合もあれば、不適切なコンテンツや有害なコンテンツ、固定観念や社会的偏見を助長させる可能性のある新しいコンテンツを生成することもあります。

- セキュリティ、プライバシー、リスク、コンプライアンスへの配慮を確実に最初から組み込むために、適切な部門横断型チームを編成します。

-

ステップ 3 - AI の入門ガイドによりチーム内で認識を共有する

- チームが AI に関して、ビジネスへの活用、高まり続ける複雑性、リスク、セキュリティ管理について評価を行う際には、関係者全員が AI モデル開発ライフサイクルの基本 や AI の能力、メリット、制限を含むモデル開発の設計や論理を理解していることが非常に重要です。

-

ステップ 4 - SAIF の 6 つの基本要素を適用する

- これらの要素は、上記の順番どおりに適用する必要はありません。

最新情報を随時ご確認ください。Google は引き続き、AI アプリケーション開発のベスト プラクティスとともに、セキュア AI フレームワークのリソースやガイダンス、ツールを構築し、共有していく予定です。

すべての人のための安全な AI コミュニティの構築を推進する理由